AI威胁指南:了解机器学习模型的网路攻击

文章重点

ALM攻击无需恶意行为者具备模型或训练数据的深入知识。生成式AI对滥用的风险独具一格,相较于预测性AI。攻击者可能通过远端方式中毒数据来源,注入恶意提示。NIST警告目前尚无万无一失的保护AI免受攻击的方法。美国国家标准与技术研究所NIST于1月4日发布了一份有关针对或利用机器学习模型的网路攻击的AI威胁指南。这份近100页的报告名为《对抗性机器学习:攻击及减缓策略的分类与术语》,全面回顾了随著预测性与生成式AI工具在过去几年迅速发展所带来的网路安全与隐私风险。

这份新的指南关于对抗性机器学习ALM的定义、分类及减缓策略,是NIST负责任和可信AI倡议的一部分,由NIST的计算机科学家和来自东北大学及Robust Intelligence Inc的专家共同撰写。

以下是对于网路安全专业人士、AI开发者及AI工具使用者需要注意的四个要点:

1 ALM攻击可在缺乏模型或训练数据的知识下进行

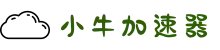

NIST指南将ALM攻击根据攻击者知识分为三类:白盒攻击、灰盒攻击和黑盒攻击。黑盒攻击尤其值得注意,因为这类攻击涉及对模型或其训练数据几乎一无所知的攻击者。相反,白盒攻击是指威胁角色对AI系统拥有完整的知识,而灰盒攻击则是对模型架构有一定了解但不熟悉其参数的情境。

不应仅因AI工具为闭源或来自可信模型提供者而假设其安全。黑盒攻击者,拥有的信息与普通公众相同,可以利用各种方法提取模型信息和私有数据,甚至降低某些机器学习工具的性能。例如,黑盒规避攻击中,威胁行为者可以通过设计特定查询来对预测AI模型进行试探,从而了解其预测标签和置信分数,这使得攻击者能够识别模型的弱点并最终设计出可以欺骗模型的对抗样本。

抵御这类攻击并不容易,因为研究表明,仅用不到1000个查询就能成功完成规避攻击,使得这些攻击不易受到查询量限制的影响。

在另一种情况下,黑盒攻击者可能会精心设计提示来“越狱”大型语言模型LLM,使其生成私有信息或制作恶意内容,如钓鱼电子邮件和恶意软件。

小牛加速器教程2 生成式AI相较于预测性AI具有独特的滥用风险

作者所提供的AI威胁分类将ALM攻击分为四个主要类别,根据攻击者的目标和目的:可用性崩溃、完整性违反、隐私妥协和滥用。

虽然前面三个分类适用于预测性和生成式AI,但滥用类别则专属于生成式AI,涵盖了由于LLM和图像生成工具的迅速发展,逐渐引起关注的威胁。

生成式AI系统的攻击分类。来源:NIST

滥用违